共计 2920 个字符,预计需要花费 8 分钟才能阅读完成。

原作者:Dean Takahashi

文章出处:https://venturebeat.com/ai/nvidia-unveils-next-gen-blackwell-gpus-with-25x-lower-costs-and-energy-consumption/

编译:裴先生笔记

英伟达(Nvidia)发布了下一代Blackwell图形处理器(GPU),其能耗提高了25倍,降低了人工智能处理任务的成本。

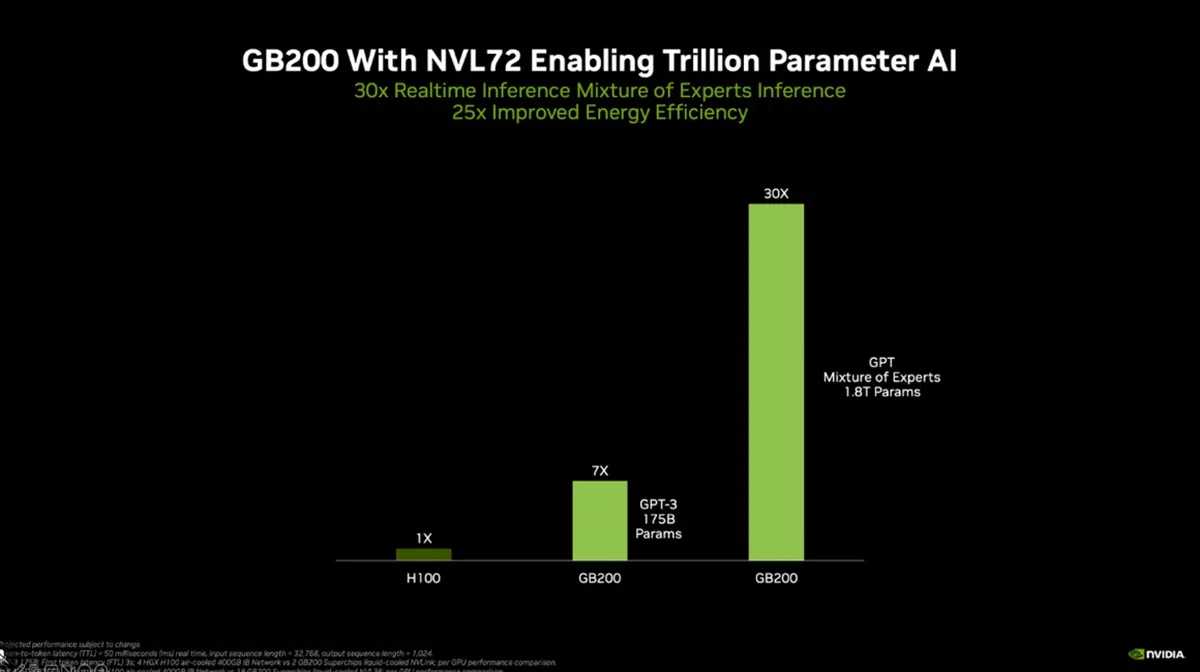

Nvidia GB200 Grace Blackwell 超级芯片(即在同一封装中包含多个芯片)有望带来卓越的性能提升,与之前的迭代产品相比,LLM 推理工作负载的性能最多可提升 30 倍。

在 Nvidia GTC 2024 的主题演讲中,Nvidia 首席执行官黄仁勋向数千名工程师揭开了 Blackwell 的神秘面纱,并表示这将预示着计算领域的变革时代。游戏产品可能稍后推出。

在主题演讲中,黄仁勋开玩笑说,他手中的原型产品价值 100 亿美元和 50 亿美元。这些芯片是 Grace Blackwell 系统的一部分。

“三十年来,我们一直在追求加速计算,目标是实现深度学习和人工智能等变革性突破。”生成式人工智能是我们这个时代的决定性技术。Blackwell GPU 是推动这场新工业革命的引擎。通过与全球最具活力的公司合作,我们将实现人工智能对各行各业的承诺。”

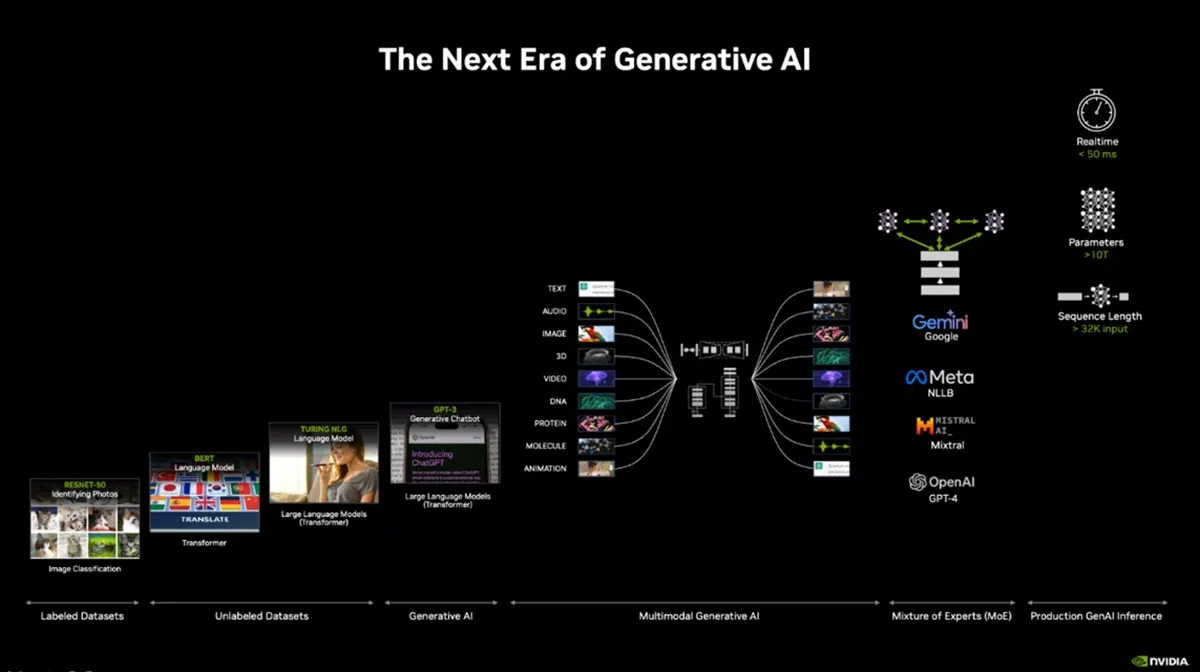

关于改进的具体内容,Nvidia表示,基于Blackwell的计算机将使各地的组织能够在万亿参数的大型语言模型上构建和运行实时生成式人工智能,其成本和能耗比其前身Hopper低25倍。处理能力将扩展到多达 10 万亿个参数的人工智能模型。

这些数字非常重要,因为 Nvidia 在低端市场面临着推理芯片设计公司 Groq 和 Cerebras 等高端 CPU 供应商的竞争,更不用说 AMD 和英特尔了。Groq 是一家总部位于加州山景城的竞争对手,专注于推理芯片,而非人工智能训练芯片。

Blackwell 平台的命名是为了纪念第一位入选美国国家科学院的黑人学者数学家大卫-哈罗德-布莱克韦尔(David Harold Blackwell),它继承了 Nvidia Hopper GPU 架构,为加速计算设立了新的标准。

GPU 最初主要用于游戏图形处理,如今已成为人工智能处理背后的主要引擎,这也是 Nvidia 市值达到 2.2 万亿美元的原因。这也是 CNBC 的吉姆-克莱默(Jim Cramer)等人在 Nvidia GTC 上进行现场直播的原因。

该平台介绍了六项有望在各个领域实现突破的先锋技术,包括数据处理、工程模拟、电子设计自动化、计算机辅助药物设计、量子计算和生成式人工智能。

世界上最强大的芯片

黄说,Blackwell 将是世界上最强大的芯片。Blackwell 架构的 GPU 拥有 2080 亿个晶体管,采用定制的双列限 4NP TSMC 工艺制造,处理能力非常强大。

Blackwell 采用第二代变压器引擎。变压器引擎配备了全新的微张量缩放支持和先进的动态范围管理算法,通过创新的 4 位浮点人工智能推理能力,将计算和模型规模扩大了一倍。

Nvidia 还发布了第五代 NVLink 网络技术。最新迭代的 NVLink 可增强多参数 AI 模型的性能,为每个 GPU 提供突破性的双向吞吐量,促进无缝高速通信。

NVLink 可为每个 GPU 提供 1.8TB/s 的双向吞吐量,确保多达 576 个 GPU 之间的无缝高速通信,满足当今最复杂的 LLM 的需求。

此外,它还有一个 RAS 引擎。Blackwell GPU 集成了专用引擎和基于人工智能的预防性维护功能,可确保可靠性、可用性和可维护性,从而最大限度地延长系统正常运行时间并降低运营成本。

它还有一个安全的人工智能解决方案。先进的保密计算功能可在不影响性能的情况下保护人工智能模型和客户数据,满足对隐私敏感的行业的需求。

专用解压缩引擎支持最新格式,可加速数据库查询,提升数据分析和数据科学性能,彻底改变数据处理方式。

该超级芯片是英伟达GB200 NVL72的基石,这是一款机架规模的系统,拥有1.4 exaflops的人工智能性能和30TB的高速内存。

Blackwell平台预计将在主要云提供商、服务器制造商和领先的人工智能公司(包括亚马逊、谷歌、Meta、微软和OpenAI)中得到广泛应用,为各行各业的计算带来变革。

Blackwell 将面向数据处理、工程仿真、电子设计自动化、计算机辅助药物设计、量子计算和生成式人工智能领域的计算客户,这些都是 Nvidia 的新兴产业机会。

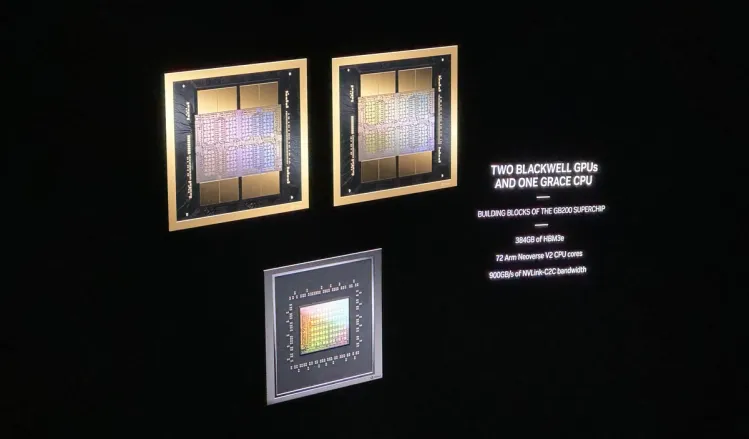

Nvidia GB200 Grace Blackwell 超级芯片通过 900GB/s 超低功耗芯片到芯片链路将两个 Nvidia B200 张量核 GPU 连接到 Nvidia Grace CPU。与Nvidia H100 Tensor Core GPU相比,GB200超级芯片在LLM推理工作负载方面的性能最多可提高30倍,成本和能耗最多可降低25倍。

GB200 是 Nvidia GB200 NVL72 的关键组件,NVL72 是多节点、液冷、机架规模的系统,适用于计算最密集的工作负载。它结合了36个Grace Blackwell超级芯片,其中包括72个Blackwell GPU和36个Grace CPU,通过第五代NVLink互连。

此外,GB200 NVL72还包括Nvidia BlueField-3数据处理单元,可在超大规模人工智能云中实现云网络加速、可组合存储、零信任安全和GPU计算弹性。该平台作为单个 GPU,具有 1.4 exaflops 的 AI 性能和 30TB 的快速内存,是最新 DGX SuperPOD 的基石。

Nvidia 推出的服务器板 HGX B200 可通过高速互连连接 8 个 B200 GPU,支持全球最强大的基于 x86 的生成式人工智能平台。HGX B200 通过 Nvidia Quantum-2 InfiniBand 和 Spectrum-X 以太网网络平台支持高达 400Gb/s 的网络速度。

GB200 还将在 Nvidia DGX Cloud 上提供,这是一个与领先的云服务提供商共同设计的人工智能平台,可为企业开发人员提供构建和部署高级生成式人工智能模型所需的专用基础设施和软件。AWS、谷歌云和甲骨文云基础设施计划在今年晚些时候托管基于 Nvidia Grace Blackwell 的新实例。

思科(Cisco)、戴尔科技(Dell Technologies)、惠普企业(Hewlett Packard Enterprise)、联想(Lenovo)和超微(Supermicro),以及爱华仕(Aivres)、华擎机架(ASRock Rack)、华硕(ASUS)、依维登(Eviden)、富士康(Foxconn)、技嘉(Gigabyte)、英业达(Inventec)、和硕(Pegatron)、QCT、纬创(Wistron)、威联(Wiwynn)和中科系统(ZT Systems)预计将提供基于 Blackwell 产品的各种服务器。

GPU是未来的黄金